Deepfake, deepvoice, spear phishing: drie imitatietechnieken die je moet kennen

De afgelopen maanden zijn sociale media overspoeld met nep afbeeldingen: paus Franciscus in een Balenciaga-donsjack, president Macron tijdens protesten tegen pensioenhervorming, en voormalig president Donald Trump in confrontatie met de politie. Verschillende kunstmatige intelligentie tools die worden gebruikt om dit soort inhoud te genereren (zoals Midjourney, DALL-E, en anderen) zijn toegankelijk voor iedereen, en blijven verrassen door hun eenvoud.

Deze nep inhoud zaait gemakkelijk verwarring bij degenen die ze bekijken. Vormen van misleiding zoals deepfakes, deepvoices en spear phishing worden steeds vaker door cybercriminelen gebruikt om desinformatie te verspreiden of om gebruikers te misleiden en gevoelige informatie te verkrijgen. Omdat de mens de zwakste schakel blijft in bedrijfsbeveiliging, is het belangrijk om deze risico's van misleiding op te nemen in benaderingen van cybersecurity-bewustwording.

Hoe werken deze verschillende vormen van misleiding en hoe kun je ze herkennen? Laten we de stand van zaken opmaken, met voorbeelden en advies.

Deepfake

Definitie en uitvoering

Deepfake is een techniek waarbij artificial intelligence (AI) wordt gebruikt om een foto, video of audiofragment (ook wel deepvoice genoemd) te genereren of aan te passen. De geproduceerde content is op het eerste gezicht erg realistisch en daarom moeilijk te detecteren, tenzij je bewust bent gemaakt van het feit dat de content gefabriceerd is. Verschillende beroemdheden (acteurs en politici bijvoorbeeld) zijn regelmatig te zien in deepfakes video's.

Hoewel deepfake altijd gebaseerd is op het misbruiken van afbeeldingen, kan het ook technische varianten omvatten zoals face swap (projectie van de gelaatstrekken van een persoon op het gezicht van iemand anders), face to face (een techniek die lijkt op face swap maar waarbij alleen de mond wordt gebruikt en over het gezicht van het model heen wordt geplaatst) en lip sync (een techniek waarbij lipbewegingen worden aangepast om ze te synchroniseren met de nieuwe stem en zo nog realistischer te doen lijken).

Tools voor het maken van deepfakes zijn nu voor iedereen beschikbaar. De deepfakes van Tom Cruise, die in 2021 viraal gingen op het social media netwerk TikTok, maakten het gebruik van deze gefabriceerde content populair bij het grote publiek. Ook politici zijn te zien geweest in deepfakes, voornamelijk in situaties waarin hun identiteit werd misbruikt.

Bijzonder populair, gemakkelijk toegankelijk en met inhoud die zeer realistisch oogt, wordt deze technologie steeds vaker gebruikt bij cyberaanvallen. Tussen 2021 en 2022 steeg het gebruik van deze technologie met 13%, volgens een rapport van een uitgever van cybersecurityproducten dat in augustus 2022 werd gepubliceerd [1]. In dergelijke gevallen gebruikt de meerderheid van de cybercriminelen video (58%), gevolgd door audio (42%). Wat betreft de kanalen die worden gebruikt om cyberaanvallen te lanceren met behulp van deepfakes, zijn e-mail (78%) de meest voorkomende, gevolgd door mobiele berichten (57%), spraak (34%) en sociale media (34%).

De risico's van onjuiste informatie en laster

De risico's van onjuiste informatie en laster in verband met het gebruik van deepfakes nemen in aantal toe en worden steeds gevaarlijker met de opmars van technologie en AI in het bijzonder.

- Misleiding en desinformatie: gebruik van deepfakes om nep informatie of desinformatie te verspreiden (met afbeeldingen of video's die onjuiste standpunten weergeven), om mensen te laten geloven dat gebeurtenissen die niet hebben plaatsgevonden, wel hebben plaatsgevonden, of dat mensen dingen hebben gezegd die ze in werkelijkheid nooit hebben gezegd.

- Intimidatie en laster: het gebruik van deepfakes om mensen lastig te vallen door gemanipuleerde video's of afbeeldingen te maken waarmee ze belachelijk worden gemaakt, belasterd of op een ongepaste manier worden neergezet.

- Manipulatie van de bevolking: verspreiding van deepfakes om de nationale veiligheid in gevaar te brengen (creatie van gemanipuleerde video's waarin politieke of militaire leiders in een ongunstig daglicht worden gesteld of nep informatie wordt verspreid), manipulatie van de publieke opinie tijdens verkiezingen of politieke debatten (creatie van gemanipuleerde video's waarin kandidaten in een gunstig of ongunstig daglicht worden gesteld). Joe Biden werd hier bijvoorbeeld het slachtoffer van tijdens de Amerikaanse verkiezingen van 2020 toen er een nepvideo werd uitgezonden waarin hij in slaap viel tijdens een interview.

Sociale media beginnen zich te realiseren welke rol ze moeten spelen in het bestrijden van dit soort content. TikTok, bijvoorbeeld, kondigde in maart 2023 aan het gebruik van AI-gegenereerde deepfakes te gaan verbieden.

Voorbeelden van deepfakes

Vooral internationale politieke figuren zijn het doelwit van deepfakes. In 2019 werd een deepfake video van de voorzitter van het Amerikaanse Huis van Afgevaardigden, Nancy Pelosi, op social media geplaatst en duizenden keren gedeeld voordat social mediaplatforms de video verwijderen. De video wekte de indruk dat ze dronken of geestelijk ziek was.

De Oekraïense president Volodymyr Zelensky was ook doelwit, met een deepfake video waarin hij het Oekraïense volk ten onrechte opriep om de wapens neer te leggen. Deze video werd kort na het begin van de oorlog in Oekraïne uitgezonden op het nieuwskanaal Ukraine 24 en op verschillende sociale media kanalen.

Als onderdeel van cyberaanvallen kunnen deepfake video's het imago van leiders misbruiken door ze onwaarheden uit te laten uitspreken.

Manieren om deepfakes te detecteren

De risico's van misbruik van deepfakes zijn enorm, dus het is belangrijk om te weten hoe je ze kunt detecteren en voorkomen. Zowel particulieren als bedrijven kunnen tools zoals Sensity gebruiken voor het opsporen van deepfakes. Deze detectietools kunnen een analyse van de videokwaliteit, een analyse van lipbewegingen en audiosynchronisatie uitvoeren, evenals een analyse van de inhoud en anomalieën. Ze kunnen worden gebruikt om de authenticiteit van afbeeldingen en video's te controleren in geval van twijfel en om gebruikers en werknemers bewust te maken van de risico's van online desinformatie.

Via het project "FAIR" (Facebook AI Research) werkt Facebook ook aan een project voor "de-identificatie". Dit moet het mogelijk maken om een filter toe te passen op video's zodat ze niet kunnen worden gebruikt door gezichtsherkenningssoftware die deepfakes zou kunnen genereren.

Deep voice

Definitie en uitvoering

Ook bekend als "deepfake audio", is deepvoice een techniek om een stem na te maken of te vervalsen met behulp van kunstmatige intelligentie. Deze technologie voor het manipuleren van audio is beschikbaar voor het grote publiek via synthetische stemgeneratoren zoals voice.ai.

Deepvoices gebruiken samples van bestaande stemopnames (podcasts, video's, enz.) om nieuwe audio-inhoud te produceren met dezelfde kenmerken als de stem in kwestie.

Wat zijn de digitale risico's van deepvoice?

Deze nagemaakte audio-inhoud wordt steeds vaker gebruikt voor kwaadaardige doeleinden, om oplichting en zelfs cyberaanvallen uit te voeren. Er zijn vijf belangrijke digitale risico’s verbonden aan deep voices.

- Vishing (voice phishing): Deze overtuigende audioberichten zetten ontvangers aan om op kwaadaardige links te klikken of persoonlijke informatie te verstrekken.

- Stemfraude: Het gebruik van audio-opnamen die de stem van iemand anders imiteren. Deze opnames kunnen worden gebruikt om mensen te laten geloven dat de imitator iemand is die ze vertrouwen (bijvoorbeeld een contactpersoon bij hun bank of een familielid) en hen misleiden om gevoelige informatie vrij te geven.

- Identiteitsdiefstal: opnames die worden gebruikt om zich tijdens telefoongesprekken of videoconferenties voor te doen als iemand anders, wat de reputatie van de persoon die zich voordoet kan schaden. Deze techniek werd gebruikt door twee Russische komieken tijdens een nep interview met de voormalige Franse president François Hollande.

- Manipulatie van democratische samenlevingen: verspreiding van geluidsopnamen die zijn gemaakt om de publieke opinie te manipuleren tijdens verkiezingen, politieke debatten of andere belangrijke gebeurtenissen.

Voorbeelden van deepvoices

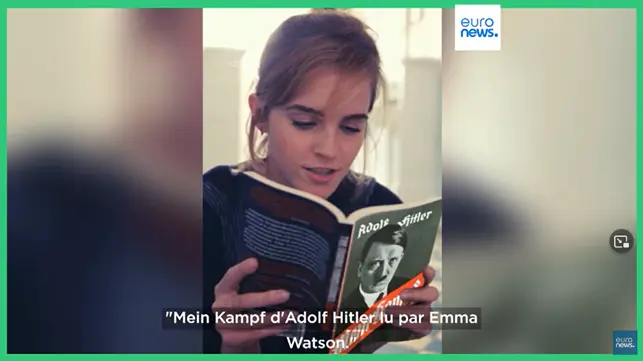

Een van de bekendste voorbeelden waarbij deep voice is toegepast is dat van de Britse actrice Emma Watson, waarvan een nep audiofragment gemaakt is waarop het lijkt dat ze Mein Kampf van Adolf Hitler voorlas. De gebruikte tool was Prime Voice, een tool voor het klonen van stemmen, ontwikkeld door de start-up ElevenLabs.

Detectiesystemen

Het detecteren van deepvoices kan bijzonder moeilijk zijn, omdat deze technologieën deep learning algoritmes gebruiken om synthetische stemmen te creëren die zeer realistisch kunnen zijn. Hier zijn een paar tips om ze te herkennen.

- Luister goed: bij deepvoices kunnen stemmen in eerste instantie natuurlijk klinken, maar subtiele verschillen in toonhoogte of intonatie kunnen hun kunstmatige aard verraden.

- Analyseer de audiokenmerken: deepvoices hebben vaak specifieke audiokenmerken die ze onderscheiden van natuurlijke stemmen. Ze kunnen bijvoorbeeld audio-artefacten bevatten (zoals abrupte onderbrekingen of achtergrondruis) die over het algemeen niet voorkomen in authentieke stemopnames.

- Gebruik detectietools: software en applicaties kunnen helpen bij het detecteren van deepvoices door de audiokenmerken te analyseren en de opnames te vergelijken met een database van bekende stemmen. Deze tools worden vaak gebruikt door beveiligingsprofessionals om pogingen tot fraude op te sporen.

- Controleer de bron van de audio-opnames: als je denkt dat je te maken hebt met een gesynthetiseerde stem, probeer dan de authenticiteit van de bron te controleren. Als de stem afkomstig is van een persoon of organisatie die je niet kent of vertrouwt, kan dit een goede indicator zijn dat je te maken hebt met een spoof.

Deze methoden zijn echter niet altijd betrouwbaar en de deep-voice technologie wordt voortdurend verbeterd. Het is daarom essentieel om rekening te houden met andere factoren (zoals de context van de opname) om te bepalen of een stem authentiek is of niet.

Spear phishing

Definitie en uitvoering

Spear phishing is een phishing techniek die bestaat uit het gericht versturen van frauduleuze e-mails naar personen of bedrijven om vertrouwelijke informatie te verkrijgen (wachtwoorden, financiële informatie of andere gevoelige gegevens) met als doel deze frauduleus te gebruiken. Zoals het ANSSI aangeeft in zijn presentatie over spear phishing, is een gerichte phishing e-mail over het algemeen gebaseerd op de imitatie van een rechtspersoon of natuurlijk persoon om de ontvanger te laten geloven dat de e-mail afkomstig is van een bekende en betrouwbare bron, en hen zo aan te moedigen een kwaadaardige bijlage te openen of op een link te klikken die hen naar een kwaadaardige website leidt.

In tegenstelling tot phishing, dat gericht is op kwantiteit, is spear phishing veel gerichter en gericht op grotere winsten. De inhoud van de e-mails is ook geavanceerder, subtieler en overtuigender.

Enkele belangrijke cijfers over spear phishing:

- Een werknemer van een bedrijf met minder dan 100 werknemers zal 3,5 keer sneller het doelwit zijn dan een werknemer van een groot bedrijf (zie studie uit een publicatie over cybersecurity).

- 64% van de beveiligingsprofessionals en 88% van de organisaties heeft al eens te maken gehad met een geavanceerde spear phishing-aanval (zie cijfers).

De risico's van spear phishing

Spear phishing is geen cyberaanval op zich, maar eerder een werkwijze die wordt gebruikt om andere acties uit te voeren: verspreiding van ransomware, gegevensdiefstal, financiële fraude, spionage, enz. Omdat spear phishing e-mails gericht en geraffineerd zijn, zijn ze over het algemeen effectief, met verstrekkende gevolgen op financieel en juridisch gebied en op het gebied van reputatie en relaties met klanten en leveranciers. Ze kunnen zelfs de deur openen naar toekomstige cyberaanvallen op grotere schaal.

Manieren van detectie en preventie

Welke methoden kunnen worden gebruikt om spear phishing op te sporen en je ertegen te beschermen? Hier zijn vijf belangrijke technieken die bedrijven kunnen gebruiken.

- Controle van het e-mailadres van de afzender: om er zeker van te zijn dat de e-mail afkomstig is van het officiële domein van het bedrijf, wordt bij deze controle gekeken naar e-mailheaders om spoofing (het vervalsen van e-mailheaders om de echte identiteit van de afzender te verbergen) en naar domeinnamen om typosquatting (het creëren van domeinnamen of e-mailadressen die lijken op die van legitieme bedrijven om gebruikers te misleiden) te detecteren.

- Analyse van de inhoud van de e-mail: om grammaticale fouten, spelfouten en verschillen in opmaak op te sporen die erop kunnen wijzen dat het om een spear phishing e-mail gaat. Met het gebruik van tools zoals ChatGPT is de spelling van spear phishing e-mails nu echter bijna perfect.

- E-mailfiltering: phishing- en spear phishing-e-mails detecteren via een domain block list en gedragsanalyse, en frauduleuze e-mails blokkeren voordat ze de inbox van werknemers bereiken.

- Bewustmaking en neppe spear phishing-campagnes: leren hoe je deze gemanipuleerde inhoud, die steeds realistischer wordt, in het echt kan herkennen.

Conclusie

AI is nu in staat om niet alleen geschreven tekst, maar ook stemmen, afbeeldingen en video's te manipuleren. Deze verschillende vormen van misbruik en manipulatie zijn zorgwekkend omdat ze de publieke opinie en de resultaten van bepaalde verkiezingen kunnen beïnvloeden. Overheden, bedrijven en individuen spelen allemaal een rol in de strijd tegen het manipuleren van informatie. Het is daarom erg belangrijk om hulpmiddelen te ontwikkelen om deze pogingen tot manipulatie op te sporen en om het bewustzijn van deze nieuwe risico's te vergroten. Zo bouw je een effectieve verdedigingsstrategie op.