Deepfake, deepvoice, spear phishing : trois techniques d’usurpation à connaître

Ces dernières semaines, les réseaux sociaux ont été inondés par de fausses images : le pape François en doudoune Balenciaga, le président Macron dans les manifestations contre la réforme de la retraite ou encore l’ancien président Donald Trump aux prises avec les forces de police. Accessibles à tous, les différentes intelligences artificielles utilisées pour générer ce type de contenu (Midjourney, DALL-E, parmi d’autres) ne cessent de surprendre par leur simplicité.

Ces faux contenus sèment facilement le trouble dans l’esprit de ceux qui les visionnent. Les techniques d’usurpation telles que les deepfakes, les deepvoices et le spear phishing sont de plus en plus utilisées par les cybercriminels à des fins de désinformation ou pour tromper les utilisateurs et tenter d’obtenir des informations sensibles. L’humain restant le maillon faible de la sécurité en entreprise, il est important d’intégrer ces risques d’usurpation dans les approches de sensibilisation à la cybersécurité.

Comment fonctionnent ces différentes méthodes d’usurpation et comment les reconnaître ? Faisons le point, exemples et conseils à l’appui.

Deepfake

Définition et fonctionnement

Le deepfake ou « hypertrucage » est une technique de synthèse utilisant l’IA pour générer ou modifier une photo, une vidéo ou encore un fichier audio (on parle alors de deepvoice). Les contenus produits sont particulièrement réalistes à première vue, et donc difficiles à détecter sans y avoir été sensibilisés. Différentes personnalités (acteurs, hommes politiques, par exemple) sont régulièrement mises en scène dans des deepfakes vidéo.

Si le deepfake repose toujours sur un détournement d’images, il peut également présenter des variantes techniques comme le face swap (projection des traits d’une personne sur le visage de quelqu’un d’autre), le face to face (une technique proche du face swap mais qui utilise uniquement la bouche et la superpose sur le visage du modèle) et le lip sync (technique qui modifie les mouvements des lèvres de manière à les synchroniser avec la nouvelle voix et donc gagner en réalisme).

Les outils de création de deepfakes sont désormais à la portée de tous. L’usage de ces contenus détournés a été popularisé auprès du grand public par les deepfakes de Tom Cruise, devenus viraux sur le réseau social TikTok en 2021. Des personnalités politiques mises en scène dans des situations détournées ont également été présentées dans des deepfakes.

Particulièrement populaire, simple d’accès et présentant des contenus criants de réalisme, cette technologie est de plus en plus utilisée dans les cyberattaques, en augmentation de 13 % de 2021 à 2022 d’après un rapport d’un éditeur de produits de cybersécurité publié en août 2022[1] . Dans ce genre de cas, les cybercriminels utilisent en majorité le format vidéo (58 %), puis le format audio (42 %). Quant aux canaux utilisés pour lancer des cyberattaques utilisant des deepfakes, il s’agit en premier lieu des e-mails (78 %), puis des messages mobiles (57 %), de la voix (34 %) et des réseaux sociaux (34 %).

Les risques de désinformation et de diffamation

Les risques de désinformation et de diffamation en lien avec l’usage des deepfakes sont de plus en plus nombreux et de plus en plus dangereux avec l’avancée des technologies, et celle de l’IA en particulier.

- Tromperie et désinformation : utilisation de deepfakes pour propager de fausses informations ou de la désinformation (avec des images ou des vidéos présentant des points de vue erronés), tromper des personnes en leur faisant croire que des évènements qui n’ont pas eu lieu ont réellement eu lieu, ou que des personnes auraient tenu des propos qu’elles n’ont en réalité jamais prononcés.

- Harcèlement et diffamation : utilisation de deepfakes pour harceler des personnes en créant des vidéos ou des images manipulées qui les ridiculisent, les diffament ou les exposent de manière inappropriée.

- Manipulation des populations : diffusion de deepfakes pour compromettre la sécurité nationale (création de vidéos manipulées qui présentent des dirigeants politiques ou militaires sous un jour défavorable ou diffusant de fausses informations), manipuler l’opinion publique lors d’élections ou de débats politiques (création de vidéos manipulées présentant des candidats sous un jour favorable ou défavorable). Pour exemple, Joe Biden en a été victime lors des élections américaines de 2020 avec la diffusion d’une fausse vidéo le montrant notamment en train de somnoler durant une interview.

Les médias sociaux commencent à prendre conscience du rôle qu’ils ont à jouer dans la lutte contre ce genre de contenus. TikTok a par exemple annoncé en mars 2023 qu’il allait interdire l’utilisation de deepfakes générés par des IA.

Exemples de deepfakes

Les personnalités politiques internationales sont particulièrement visées par les deepfakes. En 2019, une vidéo deepfake de la présidente de la Chambre des représentants américaine, Nancy Pelosi, a été publiée sur les réseaux sociaux et partagée des milliers de fois avant que les plateformes de médias sociaux ne la suppriment. Cette vidéo donnait l’impression qu’elle était ivre ou atteinte de troubles mentaux.

Le président ukrainien Volodymyr Zelensky a également été visé, avec une vidéo deepfake dans laquelle celui-ci appelait faussement la population ukrainienne à rendre les armes. Cette vidéo a été diffusée sur la chaîne d’information Ukraine 24 et sur plusieurs réseaux sociaux peu de temps après le début de la guerre en Ukraine.

Dans le cadre de cyberattaques, les vidéos deepfake peuvent détourner l’image des dirigeants pour leur faire tenir de faux propos.

Les moyens de détection des deepfakes

Les risques d’utilisation abusive de deepfakes étant nombreux, il est important de savoir comment les détecter et les contrer. Particuliers comme entreprises peuvent par exemple utiliser des outils de détection de deepfakes comme Sensity. Ces outils de détection peuvent inclure l’analyse de la qualité de la vidéo, l’analyse des mouvements des lèvres et la synchronisation audio, ainsi que l’analyse du contenu et des anomalies. Ils permettent de vérifier l’authenticité des images et des vidéos en cas de doute, et de sensibiliser utilisateurs et salariés aux risques de la désinformation en ligne.

À travers son projet « FAIR » (Facebook AI Research), Facebook travaille également sur un projet de « désidentification ». Celui-ci devrait permettre d’appliquer un filtre sur les vidéos afin de rendre impossible leur exploitation par des logiciels de reconnaissance faciale susceptibles de générer des deepfakes.

Deep voice

Définition et fonctionnement

Également appelé « deepfake audio », le deepvoice est une technique de trucage de la voix ou de son usurpation par une voix de synthèse grâce à l’intelligence artificielle. Cette technologie permettant de manipuler l’audio est accessible au grand public avec des outils générateurs de voix de synthèses tels que voice.ai.

Les deepvoices s’appuient sur des échantillons issus d’enregistrements de voix existants (podcasts, vidéos, par exemple) pour produire de nouveaux contenus audio reprenant les mêmes caractéristiques que celles de la voix en question.

Quels sont les risques cyber liés au deepvoice ?

Ces faux contenus audio sont de plus en plus utilisés à des fins malveillantes, en vue de mener des arnaques, et même des cyberattaques. Il existe cinq principaux risques cyber liés aux deep voices.

- Vishing (phishing vocal) : Ces messages audio convaincants incitent les destinataires à cliquer sur des liens malveillants ou à fournir des informations personnelles.

- Fraude vocale : À l’aide d’enregistrements audio imitant la voix de quelqu’un d’autre. Ces enregistrements peuvent être utilisés pour tromper des personnes en leur faisant croire que l’usurpateur est une personne de confiance (un contact au sein de leur banque ou un membre de leur famille, par exemple) et les amener à divulguer des informations sensibles.

- Usurpation d’identité : enregistrements utilisés pour se faire passer pour quelqu'un d'autre lors d'appels téléphoniques ou de vidéoconférences, ce qui peut causer des dommages à la réputation de la personne imitée. C’est cette technique qui a été utilisée par deux humoristes russes durant une fausse interview avec l’ancien président Français François Hollande.

- Manipulation des démocraties : diffusion d’enregistrements audio destinés à manipuler l’opinion publique lors d'élections, de débats politiques ou d'autres événements importants.

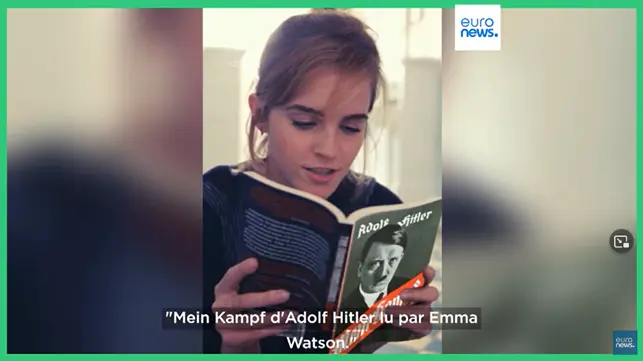

Exemples de deepvoices

L’un des exemples de deepvoices les plus connus est celui dont a été victime l’actrice britannique Emma Watson, faussement enregistrée en train de lire Mein Kampf d’Adolf Hitler. L’outil utilisé était Prime Voice, un outil de clonage de voix mis au point par le startup ElevenLabs.

Les moyens de détection

La détection des deepvoices peut être particulièrement difficile, puisque ces technologies utilisent des algorithmes de deep learning permettant de créer des voix de synthèses qui peuvent s’avérer très réalistes. Voici quelques conseils pour les repérer.

- Écoutez attentivement : dans les deepvoices, les voix peuvent sembler naturelles au premier abord, mais des différences subtiles dans la tonalité ou l’intonation peuvent révéler leur nature de synthèse.

- Analysez les caractéristiques audio : les deepvoices intègrent souvent des caractéristiques audio particulières qui les distinguent des voix naturelles. Elles peuvent par exemple contenir des artefacts audio (des coupures brusques ou des bruits de fond, par exemple) qui ne se trouvent généralement pas dans des enregistrements vocaux authentiques.

- Utilisez des outils de détection : des logiciels et applications peuvent aider à détecter les deepvoices en analysant les caractéristiques audio et en comparant les enregistrements à une base de données de voix connues. Ces outils sont souvent utilisés par les professionnels de la sécurité pour détecter les tentatives de fraude.

- Vérifiez la source des enregistrements audio : si vous pensez être confronté à une voix de synthèse, essayez de vérifier l’authenticité de la source. Si la voix provient d'une personne ou d'une organisation que vous ne connaissez pas ou à laquelle vous ne faites pas confiance, vous pourriez avoir là un bon indicateur vous indiquant que vous avez affaire à une usurpation.

Ces méthodes ne sont toutefois pas infaillibles, et la technologie des deepvoices ne cesse de s’améliorer. Il est donc essentiel de prendre en compte d’autres facteurs (tels que le contexte de l’enregistrement) pour déterminer si une voix est authentique ou ne l’est pas.

Spear phishing

Définition et fonctionnement

Le spear phishing est une technique d’hameçonnage qui consiste à envoyer des e-mails frauduleux à des individus ou à des entreprises de manière ciblée afin d’obtenir des informations confidentielles (mots de passe, informations financières ou autres données sensibles) dans le but d’en faire un usage frauduleux. Comme le précise l’ANSSI dans sa présentation du spearphishing, un e-mail d’hameçonnage ciblé repose généralement sur l’usurpation de l’identité d’une personne morale ou physique pour faire croire que l’e-mail provient d’une source connue et fiable, et ainsi inciter le destinataire à ouvrir une pièce jointe malicieuse ou à cliquer sur un lien qui le mènera vers un site web malveillant.

À la différence du phishing, qui vise la quantité, le spear phishing développe une approche beaucoup plus ciblée et vise des gains plus importants. Les contenus des e-mails sont également davantage travaillés, subtils et convaincants.

Quelques chiffres clés concernant le spear phishing :

- Un employé d’une entreprise de moins de 100 employés se verra ciblé 3,5 fois plus qu’un employé de grande entreprise (voir l’étude de l’éditeur de cybersécurité)

- 64 % des professionnels de la sécurité et 88 % des organisations ont déjà subi une attaque sophistiquée de spear phishing (voir les chiffres).

Les risques liés au spear phishing

Le spear phishing n’est pas une cyberattaque à proprement parler, mais plutôt un mode opératoire permettant de mener d’autres actions : diffusion de ransomware, vol de données, fraude financière, espionnage, etc. Les e-mails de spear phishing étant ciblés et sophistiqués, ils sont généralement efficaces, avec des conséquences en cascade sur le plan financier, juridique, d’un point de vue de la réputation et des relations avec les clients et fournisseurs. Voire de donner la possibilité de mener des cyberattaques futures de plus grande ampleur, etc.

Les moyens de détection et de prévention

Quelles sont les approches qui permettent de détecter le spear phishing et de s’en protéger ? Voici les cinq principales techniques que peuvent adopter les entreprises.

- Vérification de l’adresse e-mail de l’expéditeur : Dans le but de s’assurer que l'e-mail provient bien du domaine officiel de l'entreprise, cette vérification porte sur les en-têtes des e-mails afin de repérer une tentative de spoofing (falsification des en-têtes d’e-mail pour masquer l’identité réelle de l’expéditeur) et sur les noms de domaine pour repérer le typosquatting (création de noms de domaines ou d’adresses e-mail similaires à ceux des entreprises légitimes dans le but de tromper les utilisateurs).

- Analyse du contenu de l’e-mail : afin de détecter les erreurs de grammaire, les fautes d'orthographe et les différences de mise en forme qui peuvent indiquer qu’il s’agit d’un e-mail de spear phishing. Attention cependant, avec l’utilisation d’outil comme ChatGPT, le niveau d’orthographe des emails de spear phishing est aujourd’hui quasi parfait.

- Filtrage d’e-mail : pour détecter les e-mails de phishing et de spear phishing via des listes de blocage de domaines et des analyses de comportement, et bloquer les e-mails frauduleux avant qu'ils n'atteignent les boîtes de réception des employés.

- Sensibilisation et fausses campagnes de spear phishing : pour apprendre à repérer en conditions réelles ces contenus manipulés, qui sont de plus en plus réalistes.

Conclusion

L’IA est désormais capable de manipuler non seulement les écrits, mais aussi la voix, les images et les vidéos. Ces différents types d’usurpation et de manipulation sont préoccupants car ils sont en mesure d’influencer l’opinion publique et les résultats de certaines élections. Gouvernements, entreprises et particuliers ont tous un rôle à jouer dans cette lutte contre la manipulation de l’information. Il est donc particulièrement important de développer des outils de détection contre ces tentatives de manipulation, en les couplant à une sensibilisation accrue à ces nouveaux risques. Voilà de quoi construire une stratégie de défense efficace.